现今科技飞速进步,提升机器人智能水平的同时,如何减少计算资源消耗成为焦点。清华大学的研究团队带来了好消息,他们研发的DeeR-VLA框架有望有效解决这一难题。

研究的背景

近些年,多模态大型语言模型让机器人变得更加强大。然而,这种进步付出了高昂的代价,那就是计算和内存的巨大消耗。每一次操作都如同消耗巨额财富,而非高效完成任务。在这种背景下,清华研究者的成果显得尤为珍贵。在科研和工业领域,资源总是有限的,我们不能无限制地增加资源以追求更好的表现。尤其是对于一些小型科研机构或初创企业,他们根本无法承受庞大的计算资源消耗。

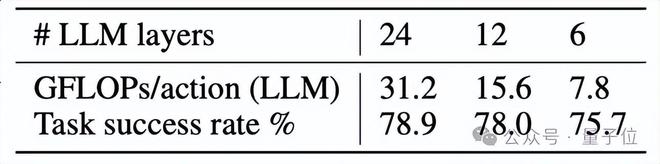

研究显示,多数任务仅需小型模型即可完成,只有在面对少数复杂场景时,才需借助大型多模态模型。以24层与6层模型为例,尽管任务完成率提升有限,但计算成本却显著上升。这一成果十分贴近实际,提醒我们无需一味追求庞大而复杂的模型。

目标的产生

提升机器人智能面临诸多挑战。要在不降低性能的前提下,如何实现计算效率的最大化?这好比寻找一种理想的平衡,既要保持平衡又不失足。稍有闪失,机器人性能可能下滑,或者计算资源被严重浪费。这一点,在机器人实际操作场景中尤为关键,例如在流水线上作业,机器人每一条指令都必须既精确又迅速,同时还要控制成本。

这个问题并非无中生有,背后有众多实验数据作为依据。在此背景下,研究者们提出根据需要调整模型大小这一目标,显得十分切合实际。

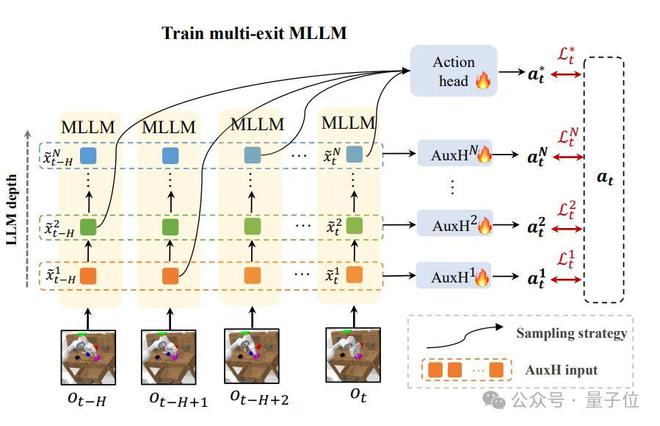

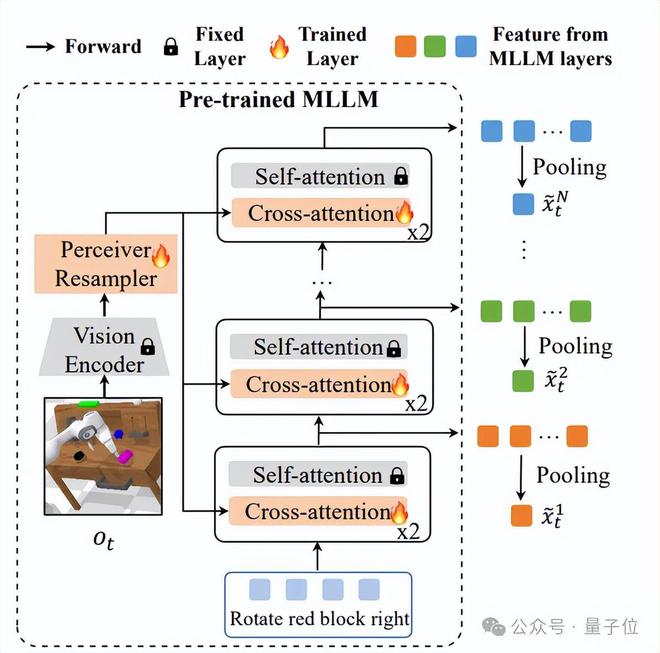

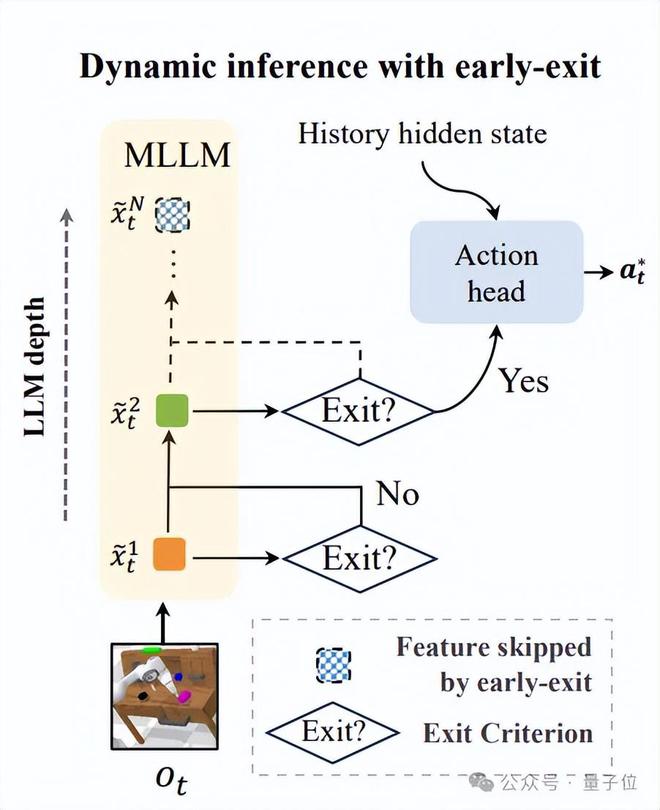

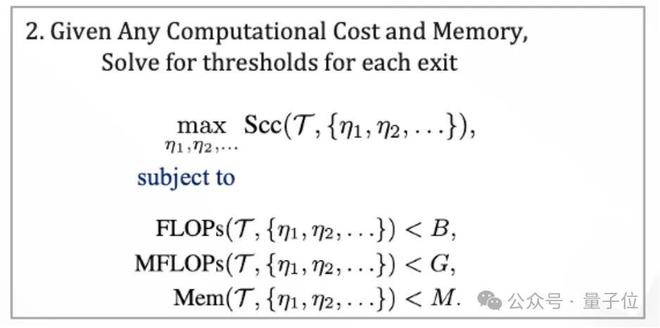

DeeR-VLA框架的核心架构多出口架构

VLA引入了多出口架构,使得在多模态大语言模型中,能够根据需求激活不同层级。这就像打开了多扇门,通常只在需要时才会开启通往资源消耗更多的那扇门。在训练或应用过程中,我们会通过探索和反馈来调整退出策略。这个过程并不简单,需要不断尝试和调整。

在动态推理过程中,模型会依据既定标准挑选恰当的路径,并整合特征进行预测。举例来说,当机器人身处复杂环境执行救援或进行高难度装配时,这种架构便能显现其优势。它能迅速处理信息,并迅速发出指令,确保出口选择的及时性与准确性。

训练阶段的特殊策略

在训练期间,模型在每个时间点都会随机挑选一个出口进行计算。这种做法看似不可思议,实则旨在确保模型能够对所有可能的出口序列进行有效学习。试想,如果训练时仅固定几个出口,那么将有许多潜在情况未能被挖掘,这样一来,在实际应用时很可能会出现疏漏。

这种策略有助于缩小训练和推理过程中的差异,从而使模型能够从容应对推理的不确定性。这并非徒劳之举,因为在面对难以预料的任务环境和需求时,它是确保机器人稳定运行的关键条件。

辅助预测头的引入

引入辅助预测头作为额外监督信号。它能提升每个出口特征的优化,有利于动作预测任务。这相当于为每个出口配备了一位小助手,这位助手专门确保输出的结果更符合作业任务的需求。在诸如工程机器人需要精确动作调度的场景中,这个小助手能确保每个指令的执行更加精确高效。

DeeR-VLA展示的优势

在基准测试中,DeeR-VLA的执行能力令人满意。尤其在任务完成率和计算效率的平衡方面,它的表现尤为出色。即便是在不同的实际环境设置中,它同样表现出色。

与其他先进技术相较,任务完成率毫不逊色,而且在LLM模块的计算资源消耗上显著减少。通过对比实际机器人在各种场景下的应用数据,这一框架在理论与实践应用上实现了完美对接。这对整个机器人及人工智能领域来说,无疑是个重大的好消息,因为它为寻求突破计算资源限制的解决方案提供了新的路径。

大家可以思考一下,这个框架在未来的机器人应用中,能在哪些新的领域展现出更大的潜力?如果觉得这篇文章对您有帮助,不妨点个赞或分享一下。