大模型训练效率问题备受瞩目。试想,只需更改一行代码,效率就能提升至1.47倍,这真是一个惊人的成就。来自得州大学奥斯汀分校的几位华人学者提出的大模型训练优化器,无疑是这一领域的一大突破。

华人学者的贡献

这几位华人学者首先要提。他们在大模型这一热门领域深耕细作,拥有丰富的学术底蕴。得益于得州大学奥斯汀分校的教育,他们打下了坚实的理论基础。这些优势帮助他们在大模型优化器研究上取得了成果。他们提出的优化器,如基于哈密顿量和下降动力学的优化器,涉及复杂理论,并不常见。这展现了华人学者在创新研究上的实力。此外,在国际化的学术环境中,华人学者抓住机遇,将理论转化为实际成果。

这一成就有助于增强华人学者在国际学术界的影响。随着更多杰出华人研究成果的涌现,全球目光将更多地聚焦于华人学术领域,也将带来更多合作机遇。

优化器适用范围广

这种优化器特别厉害,因为它能广泛地被应用。不论是语言模型还是视觉模型,都能用得上。在实际应用中,例如在工业领域,不少企业既要处理自然语言,又要处理图像视觉。这个优化器能同时满足这两类业务的需求,对企业来说,能有效节约资源。

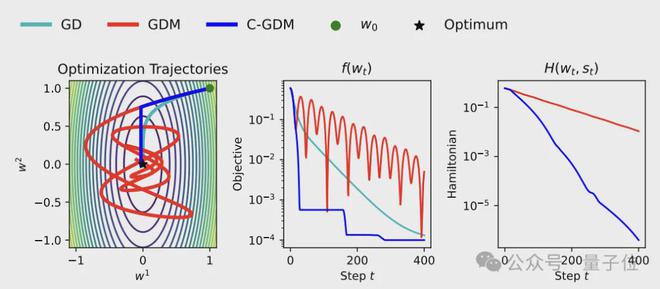

从技术层面来看,这表明优化器的理论基础具有普遍性。若优化器存在局限性,它可能仅在特定模型或任务中有效,然而,这款优化器并非如此,它在众多模型范围内均能提高训练速度。

开源与代码核心思路

研究成果的代码现已公开,同时提供了使用说明。公开代码对整个行业的发展具有正面影响。此举能让更多的小团队、独立开发者乃至学生参与到成果的优化和扩展中。

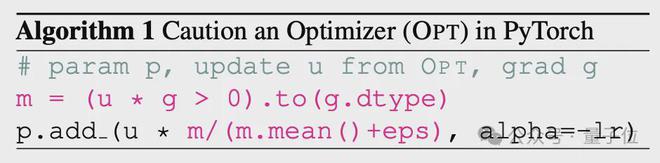

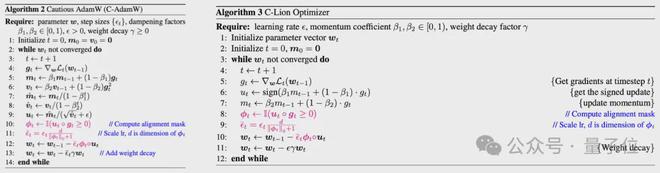

关键代码行采用的核心策略是引入一种遮挡技术。在编写代码时,通过添加两行代码来执行这一策略,具体做法是计算u和g两个向量的点积,以判断参数更新和梯度方向是否同步,从而防止参数更新方向与梯度方向发生冲突。这种处理方法展示了高效的逻辑判断能力,无需纠结方向不一致的原因,就能巧妙地提高训练效率。

加速率相关试验

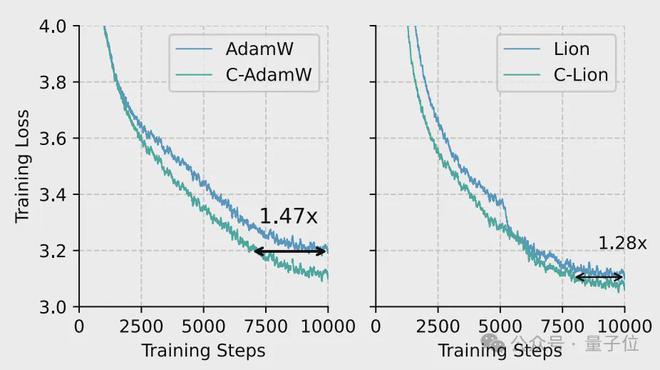

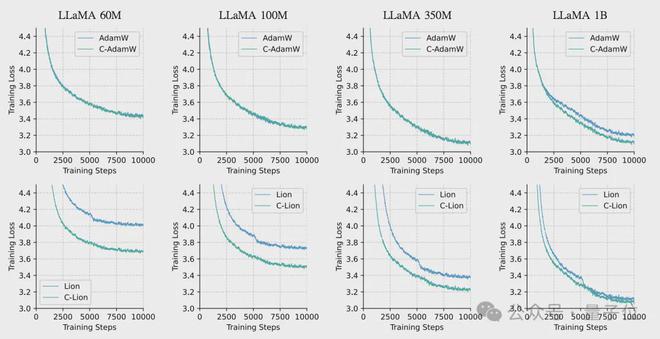

研究团队对600M至1B参数规模的Llama模型进行了测试,结果颇具说服力。测试中最高实现了47%的加速效果,这一成绩反映了效率的显著增长。具体到实验参数,比如在1万次迭代的测试中,优化器采用了AdamW和Lion及其相应版本,结果显示样本效率在不同规模模型中均有提升。

在1B模型规模上表现尤为显著,与AdamW和Lion的原版相比,样本效率分别提升了47%和28%。这些数据不仅验证了优化器的有效性,还为那些希望在此基础上继续优化或拓展研究的人员提供了切实的参考依据。

模型性能未受影响

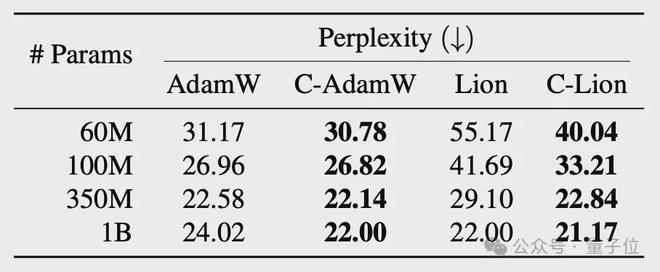

这个优化器在提高工作效率的同时,并未对模型的表现造成负面影响。比如,在泛化能力的测试中,所有情况下都实现了更低的困惑度,这就证明了这一点。另外,在诸如语句匹配、文本蕴含、情感分类等六个GLUE下游任务的具体测试中,C-AdamW的平均得分比AdamW高出2%,而且多数任务上都有所提升。

同样,在视觉模型领域,采用ViT作为核心网络,在特定数据集上对MAE模型进行预训练时,C-AdamW的最终重建误差比AdamW要低。这说明优化算法的优化策略即便省略了部分参数的更新,也不会导致模型性能的降低。

对行业影响深远

长远来看,这个优化器的问世将对大模型相关领域带来重大改变。在竞争激烈的商业战场中,训练速度的提升意味着产品能更快上市或更新。对于资源有限的一些中小型企业或研究团队来说,过去难以进行大规模模型训练,而现在因训练效率的提高,他们也有了尝试的可能。

各位读者,我想请教一个问题:这个优化器是否会被广泛采纳,成为大型模型训练的必备工具?欢迎点赞、转发这篇文章,并在评论区积极参与讨论。