Sora模型,这个备受期待的文本转视频AI模型,自年初公布以来一直未见更新,因此引起了不少争议。测试艺术家因不满而擅自公布了早期访问权限,并发布了抗议信,此事涉及诸多问题,已成为当前AI领域的一大热点。

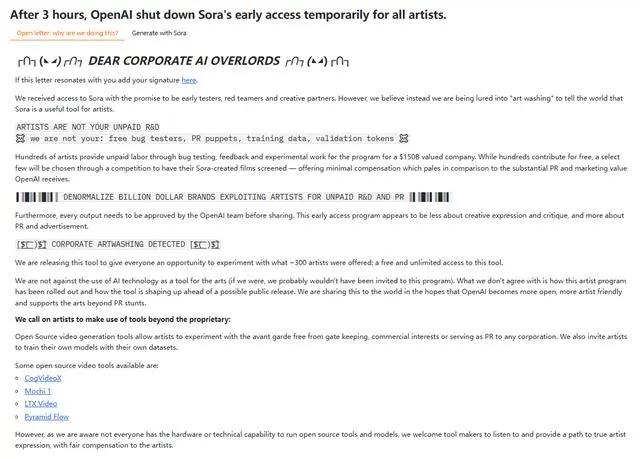

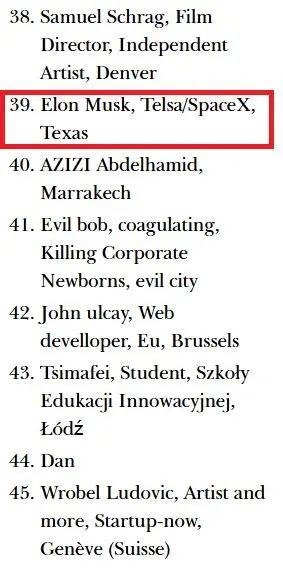

测试艺术家的不满

观察事件,原本艺术家们被许诺为项目的先行测试者和创意伙伴。然而,在测试期间,他们却感到自己被公司当作了无偿的劳力。这些艺术家拥有自己的职业自尊,在Sora项目长时间没有显著更新后,他们感到自己受到了欺骗。这种情况在艺术领域可能产生不良影响,其他艺术家在面临类似合作邀请时可能会更加谨慎。

此外,从商业伦理的角度看,公司在建立和保持合作伙伴关系方面存在重大问题。若这类问题在AI领域不能得到妥善处理,未来众多有才华的人可能不再愿意加入新项目的测试工作。这种情况无疑会对整个行业的技术更新与进步造成较大障碍。

Sora模型泄露影响

AI模型一旦泄露,绝非小事一桩。泄露后,众多未经公司严格审查的内容便会外泄。以Sora事件为例,众多人士制作了AI视频并公之于众。这些视频可能缺乏质量控制和艺术标准,极有可能误导观众。

然而,这个模型一旦泄露,很容易让人们对AI的数据安全感到忧虑。在这个大数据盛行的时代,数据保护显得尤为关键。特别是那些尚处于测试阶段的AI模型,一旦存在安全漏洞,就可能被心怀叵测的人利用,造成难以预料的严重后果。

官方回应的疑点

公司对于那起事件的反应让人难以信服。尽管官方表示参与测试的艺术家是出于自愿,且无需提供反馈或使用任何工具。然而,通过艺术家们公开发表的抗议信件,我们可以明显看出,他们在测试期间有许多要求没有得到满足。

关于Sora泄露信息的真实性尚未得到确认。这种行为似乎是在躲避问题,而这种含糊其辞的做法只会让公众对此事更加好奇,同时也增添了许多疑问,这样的态度并不利于平息当前的事件风波。

技术更新的滞后

从科技潮流的角度来看,Sora在年初的展示中,时长与质量都让人感到意外之喜。然而,过去将近一年未见更新,这确实是个不小的麻烦。在AI技术迅猛发展的当下,一年时间足以让一项技术从领先地位转变为落后。就好比一场马拉松,中途一旦停下脚步,就可能被无数追赶者超越。

Sora若在正式推出时技术落后,公司先前投入的资本将难以收回,同时面临失去市场竞争力的风险。此外,之前积累的受欢迎度也可能随之减少。

AI安全团队的变动

公司决定解散AGI团队,这一举动引人深思。原本,该团队的任务是研发与AI安全相关的解决方案。随着AI技术的飞速进步,安全问题愈发凸显。团队的解散或许意味着公司内部的战略规划有所调整。

这一调整可能会对其他企业对人工智能安全管理的态度产生影响。若连那些背后有巨头支撑的公司都在减少对AI安全领域的投资,这难道不是说明大家可能过分重视技术进步而忽视了安全问题吗?

向官方展示未发布技术的利弊

向决策者介绍草莓模型存在较大争议。这样做确实增强了公开性,有助于政府更深入地认识AI技术的进展。美国的国家安全官员通过这一展示,能直接获取新技术发展的最新资讯,进而对相关政策措施进行优化。

然而,从开发者的视角来看,一旦技术被政策制定者认为存在风险,这无疑会对技术开发的进展带来重大打击。此外,这样的做法还可能暴露商业机密等关键信息。

你觉得这件事接下来会怎么演变?这事挺复杂的,希望各位能点个赞、转发一下、讨论讨论,也希望更多真相能逐渐显现出来。