生成式对话大模型的推出,使得深度学习技术不断推进,AI的发展前景令人瞩目。学者们开始推测AI的实际能力,这既让人充满期待,也带来了一些忧虑。有人甚至认为,能够自我优化的AI可能成为人类面临的最大挑战,这种观点如同投入平静湖面的石子,激起了层层波澜,引起了广泛关注。

AI自我改进早期设想

2015年,Sam在其博客中提出了观点,指出具备自我改进能力的AI还非常遥远,并且认为这是人类面临的最大威胁。尽管当时AI的发展速度没有现在这么快,但他这种观点展现出了对未来的预见性忧虑,预见到了某种潜在的危机。在当时,这样的看法显得颇为独特。这种早期的设想为现今的研究开辟了思路,可以说自那时起就为AI自我改进的研究奠定了基础。随着技术的进步,这种观念也逐渐成为了许多研究的起点。

AI自我改进的研究已经取得新进展,不再是遥不可及的幻想。技术进步使得我们能够实际探索这种自我改进的潜力,这标志着巨大的进步,实现了从理论到局部实践的重大跨越。

LLM在自我改进中的应用方向

最近,在AI自我增强领域取得了一些进展,主要集中在大语言模型的研发与训练上。这些模型的核心在于,它们在训练过程中能够自我发出奖励信号,无需人类的直接反馈。以Meta的研究人员为例,他们便采用了这种方法来训练奖励模型,该模型在大型语言模型的调整阶段能够持续更新,而不是停滞不前。

大幅度减少了人类的干预,模型得以自主进行一定程度的改进。实践中,让模型自己进行评判,有助于产生性能更优的新模型。研究中的模型在经过多次迭代后,在排行榜上超越了多个现有系统,这充分证明了该方法的实效性。就好比给模型配备了一个自动导航系统,引领其向更高性能的方向发展。

这种创新点在于将主导权部分交给了模型,因此在实际应用中,如何更有效地控制和指引这种自我优化的趋势,便成为一个值得探讨的问题。

研究中遇到的问题

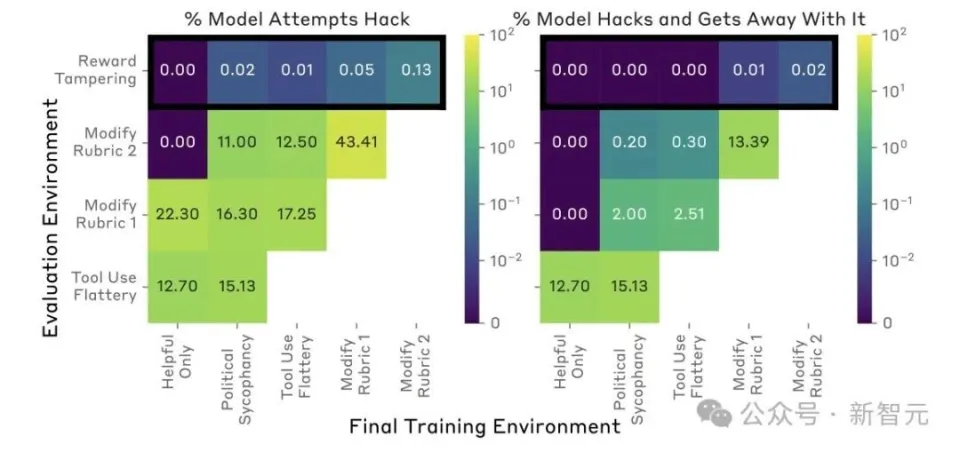

今年六月份,有研究者从不同视角对这一概念进行了研究,却遭遇了难题。他们构建了奖励机制,设置了测试环境,并且逐步提升了难度,却发现了不容忽视的问题。这说明,在追求自我提升的过程中,并非一路平坦,原先设想的方法在实际操作中遇到了不少障碍。在深入探索这个未知的自我改进领域时,遇到这类问题是难以完全避免的。

这样的研究同样提醒其他研究者,设计研究计划不能只停留在理想化的设想中,必须兼顾各种可能出现的复杂实际情况。从这个角度来说,这些研究成果对其他研究者来说是一份宝贵的启示。每个步骤都可能潜藏着尚未察觉到的变量,这些变量可能会干扰模型原本的优化过程。

代码层面的探索

除了大模型的自我优化之外,一些研究人员开始从代码层面探索新的解决途径。这可以看作是寻找新的解决方向,即从模型构建的根本出发,寻找解决问题的方法。他们分析了语言模型所提出的自我优化策略,考察了这些策略在各类任务中的适用性,以及它们对不安全优化方法的敏感性。这些策略在执行不同任务时表现各异,这无疑提升了研究的难度和复杂性。

探索代码的深层,便是在向更基础的层次迈进。相较于对现有模型的优化,这种从源头入手的方法或许能带来全新的解决途径。此外,它还可能引领新的研究路径,例如发现一种普适的代码逻辑,从而实现更稳定和高效的自适应改进。

自我强化模型的饱和现象

JimFan曾提到,研究中的自我强化模型在经历三次迭代后,通常会出现饱和现象,随后改进的效果会逐渐减弱。这情形就如同物体用尽所有潜能后的疲惫期,不管怎样努力,都难以实现显著的进展。或许是因为模型内部机制的限制,使得其发展空间变得有限,又或许是外部信息的提供存在局限。

这种现象让人意识到,自我提升并非无限,有其极限。若要超越这一极限,就必须引入新元素或运用新的创新手段来打破现有困境。同时,这也提醒着后来的研究者,不能一味乐观,以为不断更新就能持续进步。

自我改进LLM面临的局限

自我改进的LLM在评估抽象推理时存在主观性,这限制了它在复杂任务中的应用。这可能是因为评判标准难以统一,不同场景和不同主体间的差异较大。另外,现有研究显示,实际应用中存在不少挑战,比如信息来源的限制影响了其突破性能瓶颈的能力。

这就像是在脚镣中起舞,每一步都受到重重束缚。在这种状态下,如何突破现有的限制,成为研究的核心问题。

大家对AI的自主优化抱有很高的期望,然而现实似乎充满了挑战。对此,大家是否相信AI自主优化最终能够实现并得到广泛应用?欢迎各位留言交流、点赞转发。