在人工智能行业,模型存储所需费用和部署时的开支长期困扰着人们。Delta-CoMe技术的问世,犹如一道曙光,缓解了这一难题。其独特的压缩手段,堪称一大值得深入研究的亮点。

Delta-CoMe技术的核心要素

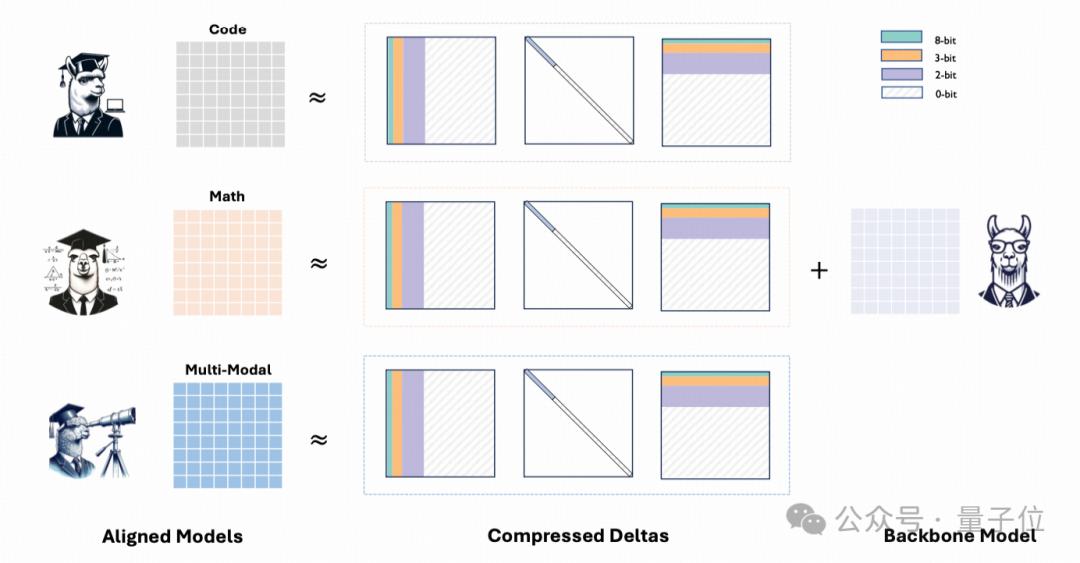

Delta-CoMe技术的精髓是运用主干模型与任务专用模型参数增量,也就是Delta的特性来进行压缩。这种思路颇为新颖,专注于Delta参数,与以往模型处理方法差异显著。比如,许多传统方法更侧重于模型自身参数的优化调整,却忽略了这种特殊参数增量的应用价值。它将低秩分解与低比特量化技术巧妙融合,这种融合方式较为罕见,而现有技术大多只采用单一手段进行压缩。

Delta-CoMe技术通过这种方式,充分挖掘了Delta参数的低秩特性。这一特性的深入挖掘至关重要,它为后续提出全新的混合精度压缩方法打下了坚实的基础,并构成了整个技术理念的核心和基础。

Delta-CoMe与其他模型的对比

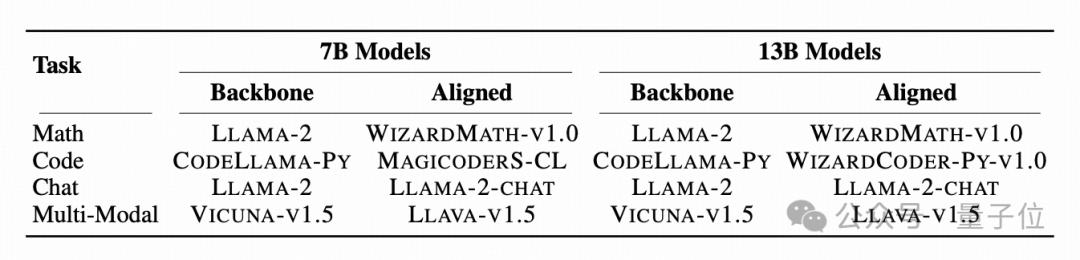

与那些通过合成高质指令数据来提升模型编码能力的方法不同,Delta-CoMe有其独特之处。它像Wei等人所做的那样,通过合成数据增强了代码处理能力,但并未从降低存储成本和部署费用的角度进行考量。

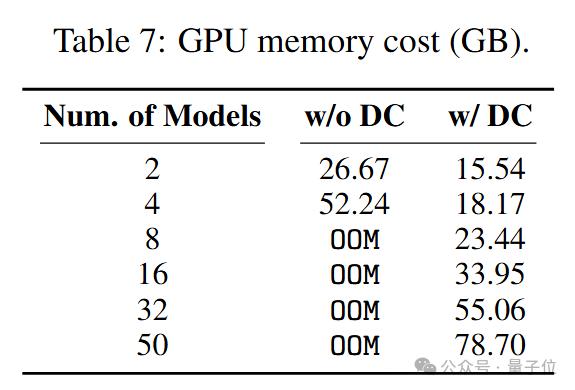

与以往单独使用通用模型作为核心,并辅助以多个具备特定功能的Delta技术相比。比如,过去的基准方案只是简单结合,并未充分挖掘Delta在压缩技术上的潜力;而Delta-CoMe技术则深入解决了存储等方面的问题。

压缩方法在复杂任务中的表现

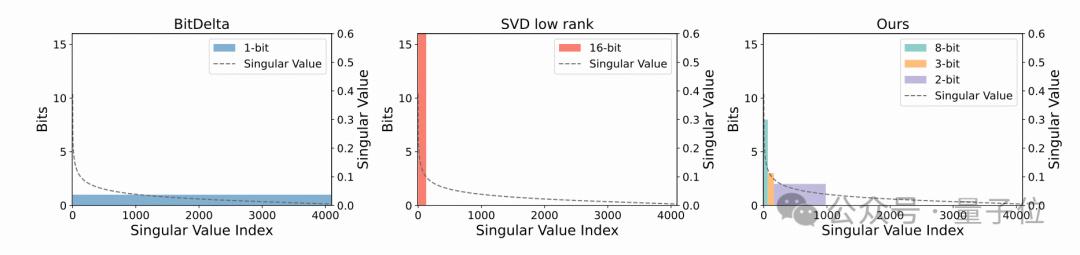

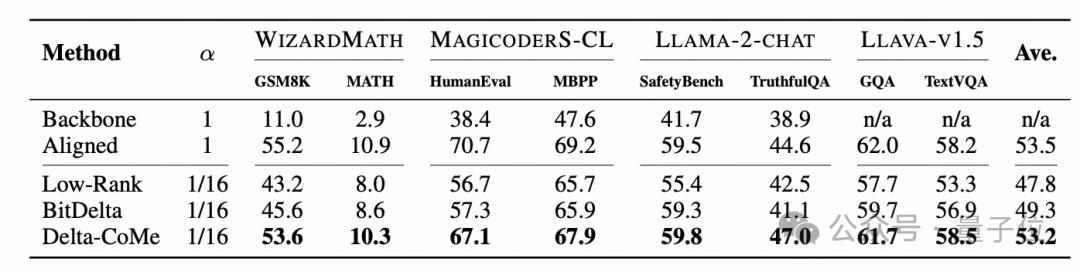

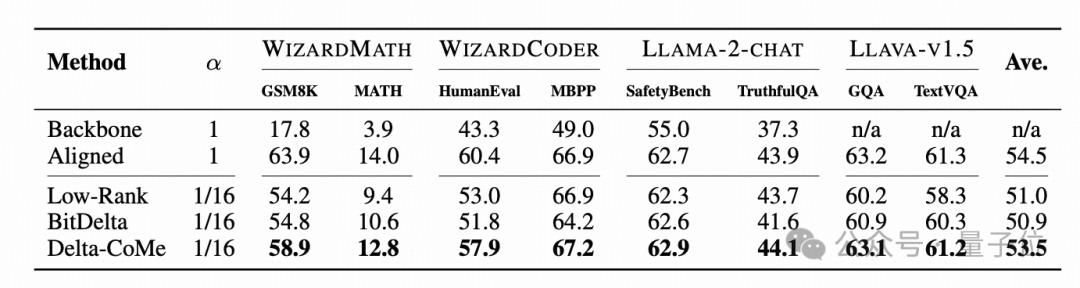

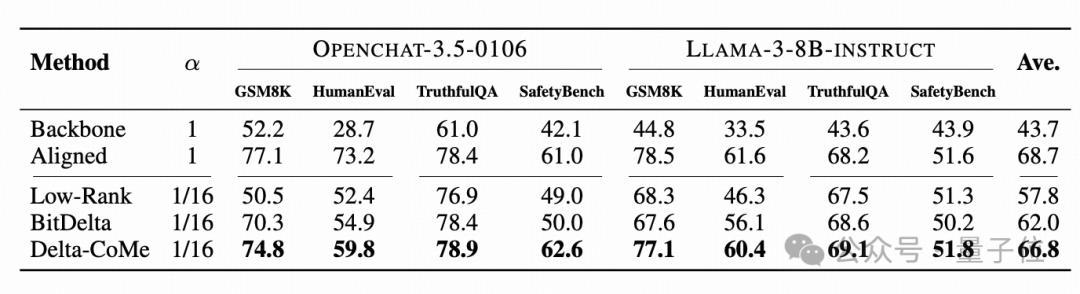

以前有人把模型的Delta压缩至1比特,尽管这种方法在问答场景中能够保持模型性能,但Delta-CoMe却表现更佳。然而,这种方法在处理更复杂的任务,例如数学推理和代码生成时,会出现性能瓶颈。

Delta-CoMe在整合了低秩分解和低比特量化技术之后,其处理复杂任务的能力实现了显著提升。在数学推理和代码生成方面,它的性能几乎没有受到影响,不会因为过度压缩而降低。

Delta-CoMe的多方面优势

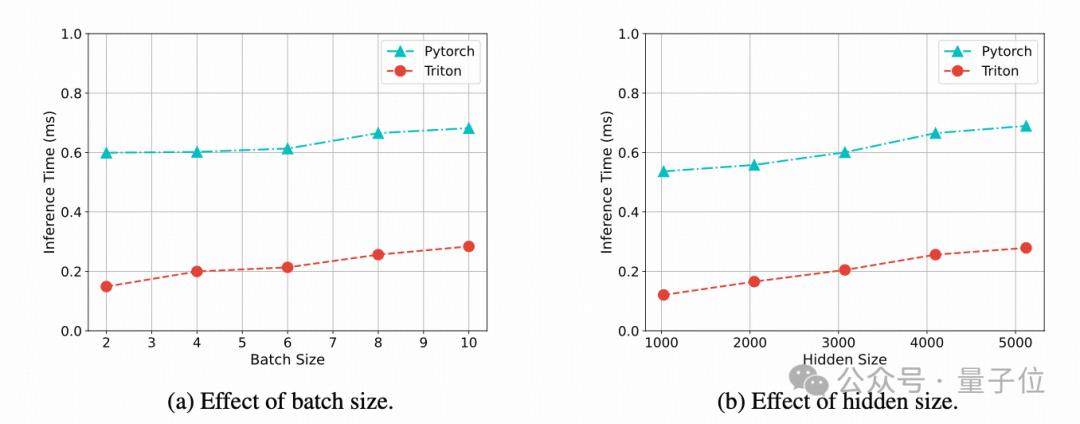

Delta-CoMe显著增强了推理速度。它为混合精度量化提供了特定的运算单元。与之前的实现方法相比,这种改进使得推理速度提升了近三倍,从而在实际应用中大幅提升了效率。

Delta-CoMe超越了一般的Delta-模型,具备多精度处理能力,这一点是其显著的优势。在效果上,它比LoRA的微调更为出色,适用范围广泛,能在不同精度层面灵活运用,满足各种任务对精度的不同需求。

混合精度量化的创新操作

Delta-CoMe在混合精度量化方面提出了独特的方法。一种直观的想法是依据奇异值的大小来实施混合精度量化,这一做法有其科学依据。在具体实施时,比如用高精度来表示较大的奇异值对应的奇异向量,而对较小的奇异值则采用低精度表示,这些都是基于数据本身的特性来决定的。

Llama-2作为核心模型后,在多任务测试中显现出卓越表现。无论是数学、编程、对话还是多模态任务,其平均表现几乎无损失,这一结果充分证实了混合精度量化策略的合理性与高效性。

Delta-CoMe的应用价值和未来展望

Delta-CoMe在应用中显示出比传统微调法更强的适应性,尤其在多租户和多任务环境中,其价值尤为显著。在多租户环境中,对存储和运行效率的需求更高,而这项技术恰好能有效地满足这些需求。

在将来,Delta-CoMe有望进一步提升模型的存储效率及推理速度,同时,它也可能对大语言模型的普及和高效运行起到促进作用。对此,我们充满期待。那么,你认为Delta-CoMe技术未来还能够在哪些领域得到更广泛的应用?欢迎点赞、转发本文,并在评论区积极参与讨论。