几小时前传出的开源信息,为大模型推理架构的进步指明了新的路径。这不仅成为行业的亮点,更标志着新的开端。

开源背景强大

清华大学作为我国顶尖学府,参与了这次开源项目。该校在计算机科学、人工智能等领域取得了显著成就,科研实力雄厚。以人工智能实验室为例,它长期致力于国家重点科研项目的承担。Kimi项目,作为与清华大学紧密合作的产物,其发展将得到双方面的推动。此外,双方在几个月前就联合发布了Kimi底层的推理系统设计方案,为项目奠定了坚实基础。

这种合作并非巧合,源于双方在技术领域的共鸣。具体来看,它体现了对技术创新的渴望。在月球的阴暗面,这种追求尤为明显。

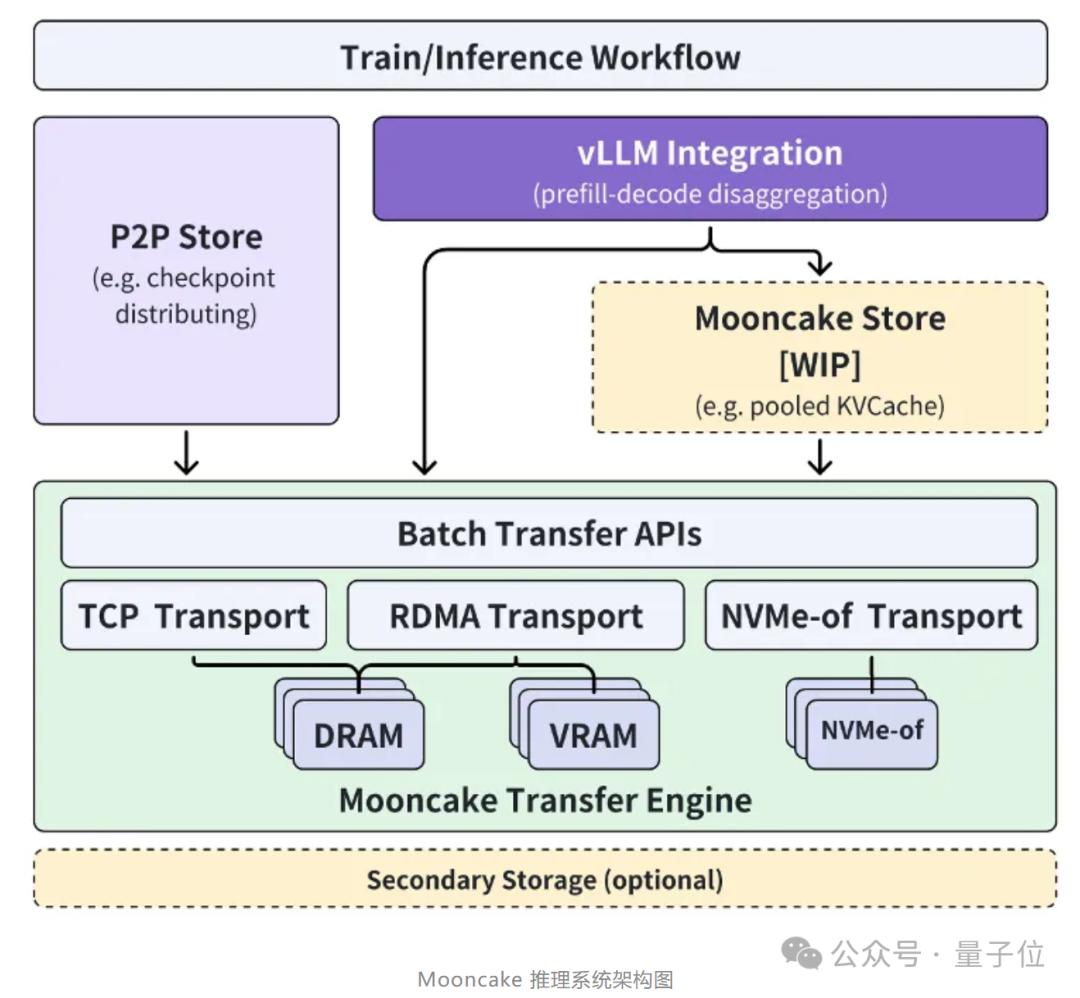

分阶段开源策略

开源并非一朝一夕之功。它将分步骤进行。首先,我们将逐步公开高性能多级缓存Store的实现细节。这部分对于提升数据处理效率至关重要,尤其在处理大量数据时,它能显著提高数据读取速度。此外,我们将确保其与多种推理引擎以及底层存储和传输资源兼容,以便于不同设备和平台的使用。我们的最终目标是创建一种新型高性能内存语义存储的标准接口,并提供相应的参考实现方案,这对整个行业都具有划时代的意义。

正常的数据处理需要兼容多种资源的缓存支持,否则难以在各类硬件环境中实现高效运行。这项开源策略对于未来的影响极为深远。

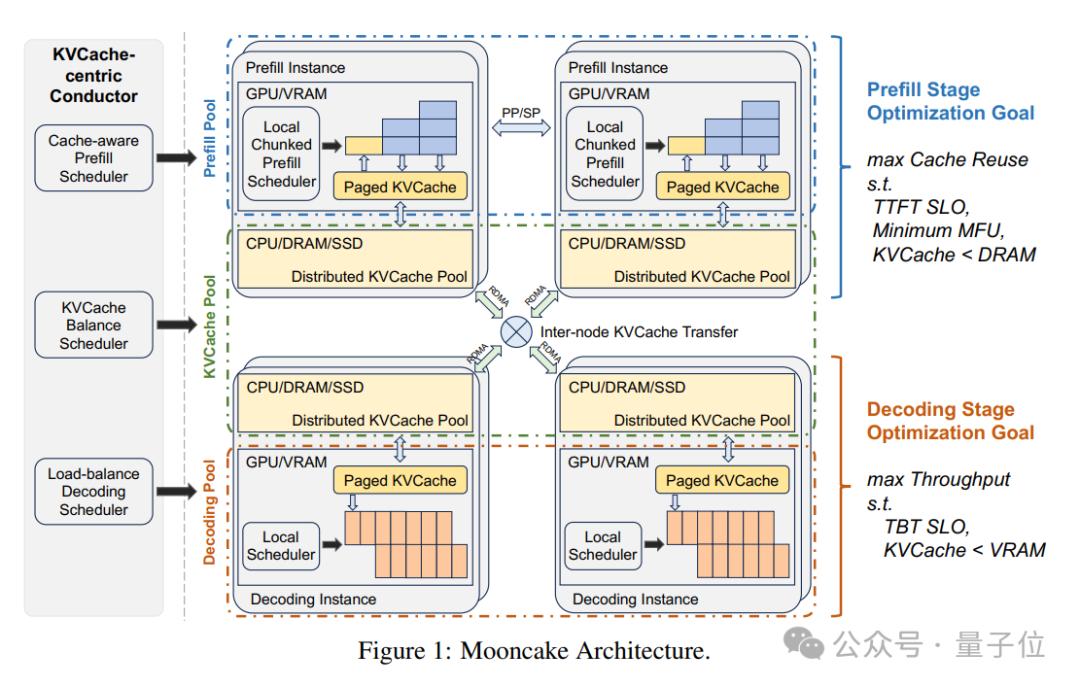

独特的推理架构

他们合力研发的分离式大模型推理结构具有重大价值。这种结构实现了推理资源的极致优化。具体到用户体验,它让Kimi的用户体验得到了改善。同时,它还大幅减少了成本,这对许多希望采用这一技术的企业和机构来说至关重要。这些技术优势在处理长文本和高并发需求方面表现得尤为明显。比如,在处理网络新闻这类长文本时,能够迅速进行内容推理;在高并发场景下,如大型网站众多用户同时提出需求时,也能轻松应对。

实际上,其设计理念与传统结构存在显著差异,这种特殊性进而带来了诸多优势。

系统技术优势

该系统采用了一种独特的技术布局。其核心在于PD分离和存换算架构。通过这种方式,系统能够有效利用GPU集群中未充分利用的资源,例如CPU、DRAM和SSD等。这样做有助于实现缓存解耦。在处理负载平衡问题上,这一架构表现出色。在流量高峰期,系统会采取早期拒绝策略和预测未来负载的措施来应对超载。这就像停车场快满时,会提前判断是否还能进车,依据是当前的空位情况和以往这个时段的车流量。

实验数据显示,论文中的实验结果比基线方法在模拟场景中提高了525%的吞吐量。同时,在实际工作负载中,它能够处理超过75%的请求。

承载流量可观

这套系统目前承担了Kimi线上超过80%的流量,这一数据充分展现了其稳定与可靠。这并非理论上的设想,而是实际运行中承受巨大压力的成熟系统。如此庞大的流量支持,既是对系统前期设计的认可,也为后续优化提供了宝贵样本。如此高的流量承载率,得益于整个架构中各个技术环节的默契协作,比如缓存系统的效率,以及资源的充分利用等。

对Kimi而言,这个系统是他运作顺畅和持续进步的稳固根基。

开源的行业意义

这次开源活动欢迎更多企业和研究机构加入。云计算、存储、AI模型等行业关键力量均可加入。通过这样的合作,我们可以共同寻求更高效、更先进的架构创新。这将让基于大模型技术的AI助手等产品,惠及更广泛的用户群体。比如,小型研发团队若直接使用这个开源项目,便能迅速开发出满足市场需求的产品。大家齐心协力,将促进该领域创新增多,进而推动整个AI行业向更佳方向迈进。那么,如果你所在的企业有类似需求,是否会愿意参与此类开源项目?