近期科技界掀起了一场风波,涉及一款名为Sora的新型文本转视频AI模型泄露。此事背后交织着诸多利益、信任和发展的矛盾,值得细细剖析。

事件缘起

年初公布了文本转视频AI模型Sora,但自那之后,进展一直停滞不前。这让参与测试的艺术家们感到非常不满。他们像期待奖励的员工一样,满怀希望地参与了测试,却只得到了毫无变化的更新。漫长的等待让他们决定公开早期访问权限。原本正常的测试合作,因为企业未能提供更新而破裂。这一举动导致大量AI视频泄露,成为矛盾激化的导火索。此外,艺术家们还通过自己的方式表达抗议,即在Face公共AI模型平台上发布了抗议信。

这种行为并非偶然发生,众多受邀参加测试的艺术家在参与前都得到了一些许诺。他们原本以为自己是首批测试者和创意伙伴。然而,现实情况却是他们似乎成了无偿的工具。这种在合作关系中对自身角色的认知差异,正是矛盾产生的根本原因。

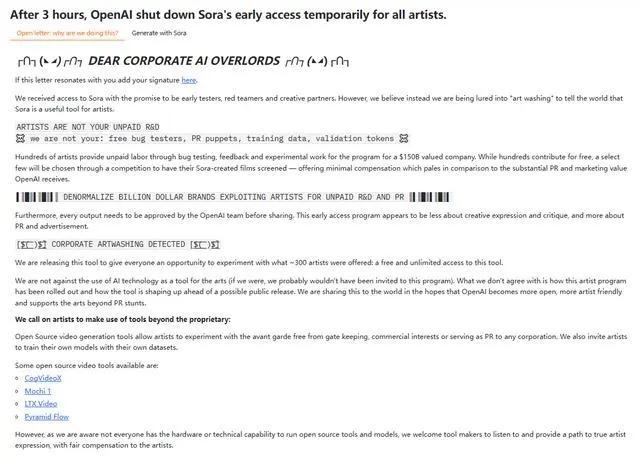

公开信风波

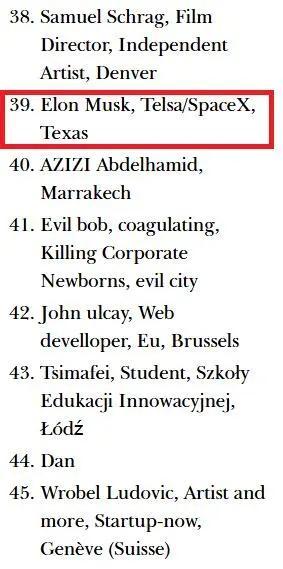

艺术家们发布的公开信影响深远。信中详述了他们遭遇的困境。他们明确表示,不愿成为免费劳动力。无论是免费测试bug,还是用作宣传或训练数据,这些都违背了他们当初参与测试的初衷。特别值得一提的是,这封信有122人联名支持,马斯克的名字更是让事件备受瞩目。这反映出众多人对这种测试中的不公平感到愤慨。在科技界,许多人认为这种对待测试者的做法是不当的。这封信如同投进平静湖中的一颗炸弹,激起了轩然大波。

媒体加入调查,在联系相关人士后,并未确认Sora泄露的准确性,却强调参与测试的艺术家无需提供反馈或使用该工具。这种说法实则难以安抚艺术家的愤怒,对解决事件的矛盾并无积极作用。

技术发展滞后隐忧

科技旋涡对此事件强调了一个关键观点。Sora年初的展示确实令人眼前一亮,视频的时长和质量都让人对新技术充满期待。然而,过去一年里未见有效更新。若这种状况持续,正式版发布时很可能落后于同行业。这就像马拉松比赛,起初领先,但中途停下脚步,结果很可能是被对手超越。这不仅仅让人对项目本身担忧,更是对AI发展更新速度的警示。若发展速度跟不上需求和技术进步,所有投入都可能白费。

安全问题凸显

Sora项目泄露首要影响的是安全问题。特别是AI模型泄露,可能造成的数据安全隐患相当严重。泄露的数据可能包含开发过程中的诸多机密。这不仅可能削弱公司的竞争力,还让众多用户对自己的数据安全产生疑虑。从更广的角度来看,若此事件持续扩大,将导致公众对依赖大量数据训练的AI公司群体产生信任危机。正如房屋墙壁出现裂缝,若不及时修复,居住其中的人会担忧整个建筑的安全可靠性。对于AI公司而言,公众的信任是其稳定发展的基石。

AGI团队解散关联

此事件与AI安全研究领域的“AGI”团队解散存在关联。该团队曾获得微软等科技巨头的支持,主要职责是为AI初创企业提供应对先进AI技术的策略和建议。然而,团队的解散导致在安全防护方面出现了一定程度的空白。过去,该团队能够对流程和防护措施进行评估和提出建议,但如今团队不复存在,一些防护措施的力量因此减弱。这就像一辆在高速公路上行驶的汽车,原本有专业的安全检测团队,但现在团队消失了,汽车安全行驶的风险自然增加了。

行业透明度影响

事件中,有公司向政府官员展示了所谓的“草莓”模型。这或许是为了增加透明度而做出的努力之一,但背后却潜藏着不小的风险。若政策制定者觉得这项技术有潜在威胁,企业可能就会遇到麻烦。由此看来,在AI行业的发展中,技术和政策的协调发展至关重要。企业既要推进技术进步,又要小心翼翼地处理与政策的关系,这就像走钢丝,一不小心就可能重重地摔下来。

最后有个疑问想请教各位:在人工智能技术不断进步的过程中,企业该如何妥善处理技术进步、与测试者的互动以及赢得公众信任这三方面的关系?欢迎大家在评论区留言,也请大家点赞和转发这篇文章,让更多人加入这场讨论。